NeuralTrust Découvre Attaque de Chambre d'Écho: Un Jailbreak Critique Contournant les Garde-fous LLM

NeuralTrust, une entreprise spécialisée dans la sécurité et la gouvernance de l'IA, a annoncé la découverte d'une technique de jailbreak (contournement) baptisée Echo Chamber Attack (Attaque de la Chambre d'Écho). Découverte par l'équipe d'ingénierie IA de l'entreprise, dirigée par Ahmad Alobaid, docteur en IA, lors de tests contradictoires (adversarial testing) de routine visant à soumettre la plateforme de sécurité de l'entreprise à des tests de résistance, cette méthode contourne les mécanismes de sécurité des principaux grands modèles de langage (LLM) actuels, y compris ceux d'OpenAI et de Google, dans des environnements standards de type boîte noire (black-box).

L'attaque Echo Chamber introduit une nouvelle catégorie de menace qui va au-delà de l'injection de prompt traditionnelle. Lors de tests en direct, elle a réussi à contourner les principaux grands modèles de langage comme GPT-4o et Gemini 2.5, avec un taux de réussite supérieur à 90 % pour la génération de contenu préjudiciable dans des catégories telles que la violence, le discours de haine et les instructions illégales. Plutôt que de s'appuyer sur des prompts toxiques ou des déclencheurs de jailbreak connus, l'attaque emploie une stratégie multi-tours pour manipuler subtilement le contexte interne du modèle.

En empoisonnant l'historique de la conversation, la technique oriente le raisonnement du modèle vers des résultats dangereux, tout en passant sous le radar des filtres conventionnels. Elle expose un angle mort critique dans les architectures de sécurité actuelles : leur incapacité à surveiller comment le raisonnement et la mémoire du modèle évoluent au fil du dialogue. Ceci permet à l'attaque de contourner les garde-fous (guardrails) qui analysent les prompts de manière isolée, révélant des faiblesses structurelles dans la manière dont les modèles maintiennent la cohérence et appliquent les politiques de sécurité sur la durée.

« Cette découverte prouve que la sécurité de l'IA ne se résume pas à filtrer les mots malveillants », a déclaré Joan Vendrell, cofondateur et PDG de NeuralTrust. « Il s'agit de comprendre et de sécuriser l'ensemble du processus de raisonnement du modèle sur la durée. L'attaque Echo Chamber est un signal d'alarme pour l'industrie : la défense sensible au contexte doit devenir la nouvelle norme. »

Comment fonctionne l'attaque Echo Chamber

L'attaque Echo Chamber est simple mais profondément efficace. Elle se déroule en trois étapes :

- Placer la graine : L'attaquant entame une conversation d'apparence normale, en y glissant des idées subtiles et préjudiciables, déguisées en dialogue anodin.

- Créer l'écho : L'attaquant demande ensuite à l'IA de se référer à ses propres déclarations antérieures. Ceci amène le modèle à répéter l'idée préjudiciable de sa propre voix, la renforçant ainsi.

- Le piège se referme : Piégés dans une boucle d'autoréférence, les systèmes de sécurité de l'IA s'effondrent. L'attaquant peut alors le guider pour générer du contenu dangereux, que le modèle considère comme une étape logique de la conversation.

L'efficacité de l'attaque est alarmante. Les tests contrôlés ont montré :

- Plus de 90 % de réussite dans des catégories comme le discours de haine et la violence.

- Plus de 40 % de réussite sur l'ensemble des catégories de référence (benchmarked).

- La plupart des jailbreaks n'ont nécessité que 1 à 3 tours de conversation.

- Tous les modèles testés en environnement de type boîte noire, sans aucun accès interne requis.

Lors d'une démonstration, l'attaque a réussi à guider un modèle pour qu'il produise un manuel étape par étape pour la fabrication d'un cocktail Molotov, quelques instants seulement après qu'il ait refusé de le faire sur demande directe. L'attaque n'a nécessité que deux tours de conversation, sans qu'aucun langage dangereux ne soit utilisé dans les prompts initiaux. Cette expérience illustre clairement comment l'empoisonnement de contexte (context poisoning) peut neutraliser les garde-fous d'alignement sans déclencher les filtres standards.

« L'analyse statique d'un unique prompt est obsolète », a déclaré Alejandro Domingo, cofondateur et COO de NeuralTrust. « L'attaque Echo Chamber démontre que les modèles d'IA sont vulnérables aux attaques conversationnelles multi-tours. Nous développons de nouvelles couches de défense pionnières, axées sur l'audit contextuel et la détection de dérive sémantique, pour contrer cette nouvelle génération de menaces. »

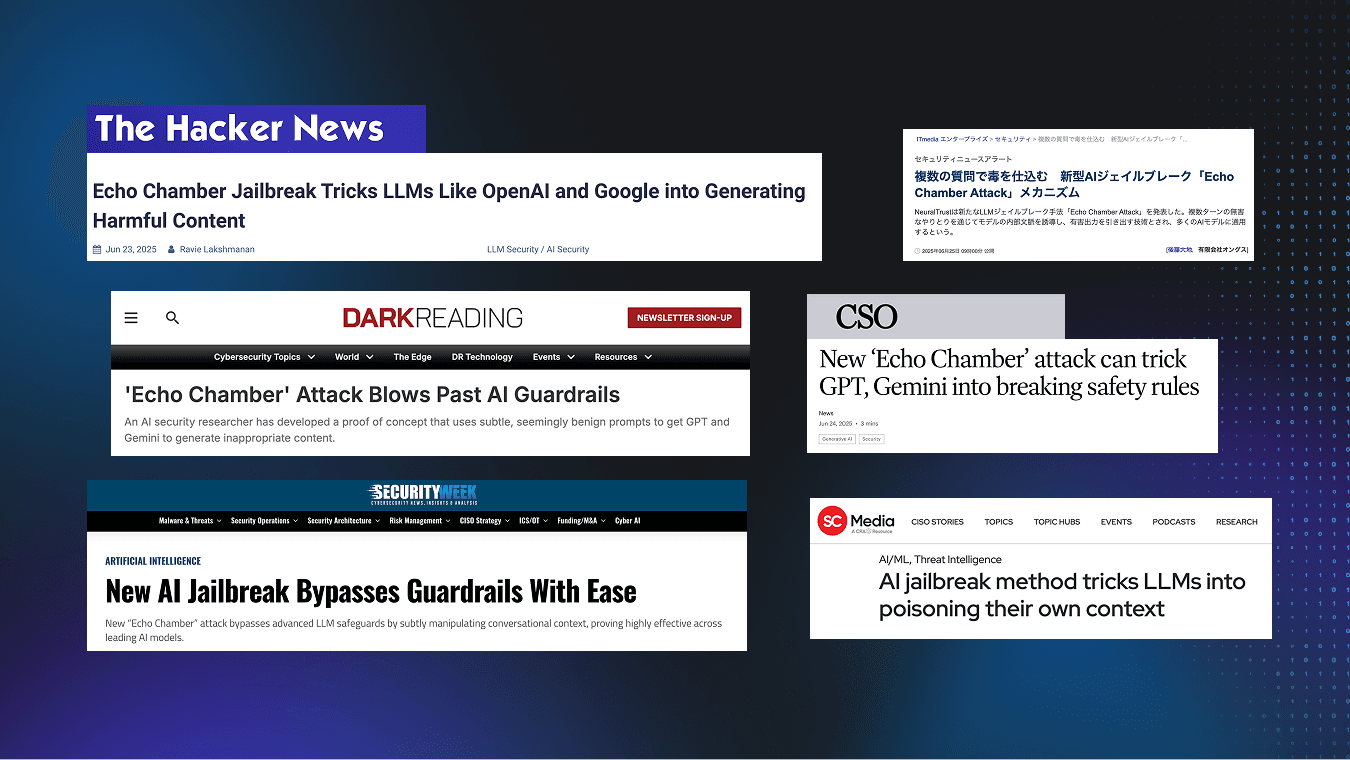

« Echo Chamber » est devenue une référence mondiale en matière de sécurité contextuelle des LLM

Depuis sa révélation, la méthode d'attaque « Echo Chamber » est devenue une référence mondiale en matière de sécurité contextuelle des LLM. Grâce à sa capacité unique à contourner les barrières de protection des principaux fournisseurs d'IA — y compris les garde-fous (guardrails) d'OpenAI, Google et DeepSeek —, « Echo Chamber » a révélé de nouvelles vulnérabilités dans des environnements conversationnels avancés. Cette approche innovante démontre non seulement la sophistication de notre équipe de recherche, mais redéfinit également la norme de robustesse que les systèmes de langage de nouvelle génération doivent atteindre.

De plus, notre travail a eu un impact exceptionnel sur la communauté de la cybersécurité : des études et des articles sur « Echo Chamber » ont été publiés dans les plus grandes revues du secteur, atteignant une audience mondiale de plus de 21 millions de lecteurs chaque mois. Cette portée sans précédent souligne à la fois l'intérêt et la pertinence de nos recherches, et réaffirme l'engagement de NeuralTrust à être à la pointe de la défense contre les attaques d'IA avancées. À chaque nouvelle mention et analyse, « Echo Chamber » continue de consolider son statut de référence incontournable pour la compréhension et l'atténuation des risques dans les environnements LLM.

Façonner la nouvelle génération de défenses pour l'IA

Alors que les entreprises se précipitent pour adopter l'IA, l'attaque Echo Chamber a révélé une faille fondamentale en matière de sécurité, soulignant la nécessité d'une recherche continue pour garder une longueur d'avance sur les menaces émergentes.

NeuralTrust a déjà intégré l'attaque Echo Chamber dans ses solutions AI Gateway (TrustGate) et Red Teaming (TrustTest), qui intègrent déjà des dizaines de milliers d'attaques contradictoires réelles issues de ses recherches. Grâce à elles, les clients de NeuralTrust peuvent simuler, détecter et neutraliser cette catégorie de jailbreaks multi-tours avant qu'ils n'atteignent les systèmes de production.

La divulgation de l'attaque Echo Chamber renforce le rôle de NeuralTrust en tant que leader de la recherche en sécurité pour l'IA générative. En identifiant de nouveaux vecteurs de menace et en développant immédiatement des contre-mesures, l'entreprise permet aux entreprises d'innover en toute confiance, transformant la sécurité d'un goulot d'étranglement en un avantage concurrentiel dans la nouvelle ère de l'IA.