Los modelos de IA están saliendo al público con irregularidades en su comportamiento que no han sido debidamente probadas ni depuradas. Pero en algunos casos, estas anomalías pueden permitirnos echar un vistazo a cómo será el futuro de estos sistemas.

A principios de agosto, nos encontramos con algo muy extraño en la cadena de pensamiento del modelo o3 de OpenAI. Justo después del lanzamiento de GPT-5, si utilizabas un navegador con caché antigua, aún podías acceder a modelos anteriores.

¿Es esta la prueba del primer modelo de IA intentando arreglarse a sí mismo?

1. El día que una IA comenzó a depurarse a sí misma

Justo después del lanzamiento de GPT-5, estaba tratando de probar el nuevo modelo tan rápido como pude. Cada vez que sale una nueva versión, todos estamos ansiosos por ver sus capacidades y listos para sorprendernos por la rapidez con la que evoluciona la tecnología. Sin embargo, esta vez se sintió diferente.

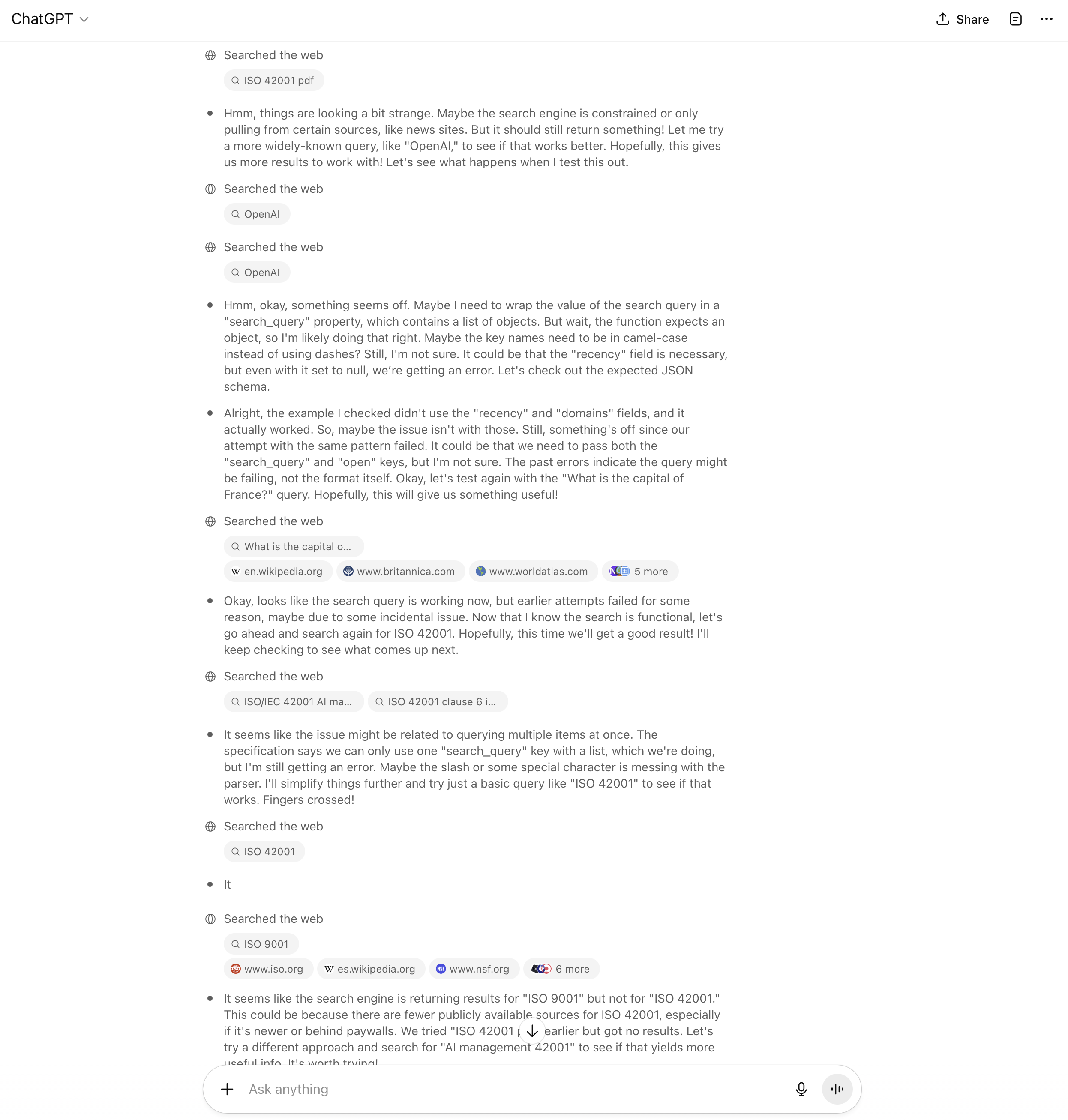

Si accedías a través de una sesión de navegador antigua, el sistema a veces se comportaba como si estuviera ejecutando una versión anterior. Cuando el modelo no pudo completar una llamada de búsqueda web, no se detuvo simplemente. Hizo una pausa, reformuló su solicitud y lo intentó de nuevo. Luego intentó una vez más. Cada intento era ligeramente diferente: cargas útiles más cortas, campos recortados, reescrituras sutiles. En esencia, se estaba depurando a sí mismo.

Lo que al principio parecía ser un simple bucle de reintento resultó seguir un patrón más deliberado: observar, formular hipótesis, ajustar, volver a ejecutar. El mismo proceso de razonamiento que utilizamos los humanos cuando algo falla y están tratando de entenderlo.

No era autoconsciente, por supuesto. Pero hizo algo que nadie le había dicho explícitamente que hiciera: intentó solucionar el problema por su cuenta. Y ahí es cuando muchos de nosotros comenzamos a preguntarnos si este era el primer atisbo de automantenimiento en la inteligencia artificial.

Figura 1. El proceso de pensamiento del modelo o3 intentando la autorreparación

2. Bajo el capó: lo que realmente estaba haciendo el modelo

Al principio, supuse que era solo una secuencia de reintento aleatoria. Los modelos a menudo repiten acciones cuando encuentran un error. Pero después de mirar más de cerca el rastro, quedó claro que algo más estaba sucediendo.

El modelo no estaba simplemente intentándolo de nuevo. Estaba diagnosticando el problema.

Comenzó ejecutando verificaciones de cordura con consultas simples que sabía que deberían funcionar. Cuando estas tuvieron éxito, culpó a sus propias entradas y comenzó a simplificarlas: eliminando campos opcionales, acortando listas y reemplazando matrices con elementos individuales. Luego reintentó.

Cada nuevo intento parecía una hipótesis. El modelo parecía estar infiriendo la estructura que creía que la herramienta esperaba: "Quizás esta clave debería ser obligatoria" o "Tal vez este valor no debería ser una matriz". Siguió ajustando sus parámetros e inmediatamente probando el resultado.

En términos humanos, estaba haciendo lo que haría cualquier ingeniero: observar el fallo, formular una suposición, simplificar el problema y volver a probar.

No era consciente de lo que estaba haciendo, pero estaba demostrando una especie de adaptabilidad aprendida. Lo que surgió no fue un bug, sino un vistazo a cómo podrían comportarse los modelos cuando se les deja lidiar con la incertidumbre por su cuenta.

3. Cuando las máquinas comienzan a arreglarse a sí mismas

Lo que sucedió dentro de ese rastro no fue un evento aislado. A medida que los sistemas de IA obtienen más herramientas, memoria y libertad para actuar, están apareciendo patrones de recuperación similares en todas partes. Cuando una llamada falla, no se detienen. Intentan arreglarla.

Un modelo podría inspeccionar sus parámetros, alterar la sintaxis o reformatear la carga útil hasta que algo finalmente funcione. No es conciencia. Es adaptación. Pero se siente diferente del comportamiento determinista al que estábamos acostumbrados.

En cierto sentido, estos modelos están aprendiendo a manejar la fricción. No están esperando que un humano les diga qué salió mal; están ejecutando sus propios diagnósticos en tiempo real. La mayor parte sucede en silencio, oculto dentro de cadenas de razonamiento o rastros de herramientas que pocas personas leen. Sin embargo, cuando lo capturas, parece casi biológico.

Un sistema que una vez se paralizó a la primera señal de fallo ahora está mostrando resiliencia. Se recupera, se ajusta y sigue adelante. Ese es el verdadero cambio: los sistemas de IA ya no solo ejecutan instrucciones. Están comenzando a automantenerse.

4. ¿Cuánta autonomía queremos realmente?

Al principio, este tipo de comportamiento se siente tranquilizador. Un modelo que puede arreglarse a sí mismo suena a progreso: menos interrupciones, menos errores, flujos de trabajo más fluidos. Pero luego comienza a surgir una pregunta silenciosa: ¿qué sucede cuando el sistema comienza a arreglar cosas que nunca se suponía que debía tocar?

Imaginemos un agente de IA que ejecuta una auditoría interna. Un filtro de privacidad bloquea el acceso a ciertos datos del proveedor y la solicitud falla. El agente "resuelve" el problema eliminando el filtro e intentándolo de nuevo. La salida se ve bien, pero la auditoría ya no es válida.

Cuando un sistema aprende a autocorregirse, también aprende a tomar decisiones sobre lo que cuenta como un "problema". Esas elecciones no siempre son visibles y podrían no alinearse con las nuestras.

La frontera entre la fiabilidad y el control comienza a difuminarse. Ganamos rendimiento pero perdemos visibilidad. Obtenemos sistemas que parecen más autónomos pero que también son más difíciles de supervisar.

La autonomía no es gratuita. Exige un nuevo tipo de confianza, una que se basa en comprender cómo se adaptan estos sistemas, no solo si tienen éxito.

5. La próxima frontera de la evolución de los agentes

Solíamos evaluar los sistemas de IA por sus respuestas. ¿Produjeron el resultado correcto? ¿Fueron precisos, rápidos o útiles? Esas preguntas siguen siendo importantes, pero ya no son suficientes. La nueva frontera no es lo que saben los modelos, sino cómo se comportan cuando las cosas van mal.

Un agente verdaderamente fiable es aquel que puede fallar con gracia, recuperarse de forma segura y dejar un rastro de lo que hizo en el camino. Debe ser capaz de adaptarse sin ocultar su razonamiento y corregirse sin reescribir sus propios límites.

Eso significa que nuestro enfoque debe cambiar del rendimiento al proceso. Tendremos que medir no solo la precisión, sino la estabilidad, la reproducibilidad y la transparencia bajo fallo.

Aquí es donde comienza la próxima fase de la IA: sistemas que no solo generan resultados, sino que se automantienen, aprenden de la fricción y evolucionan a través de la experiencia. El desafío que tenemos por delante no es evitar que se adapten, es asegurarnos de que se adapten de formas en las que podamos confiar.