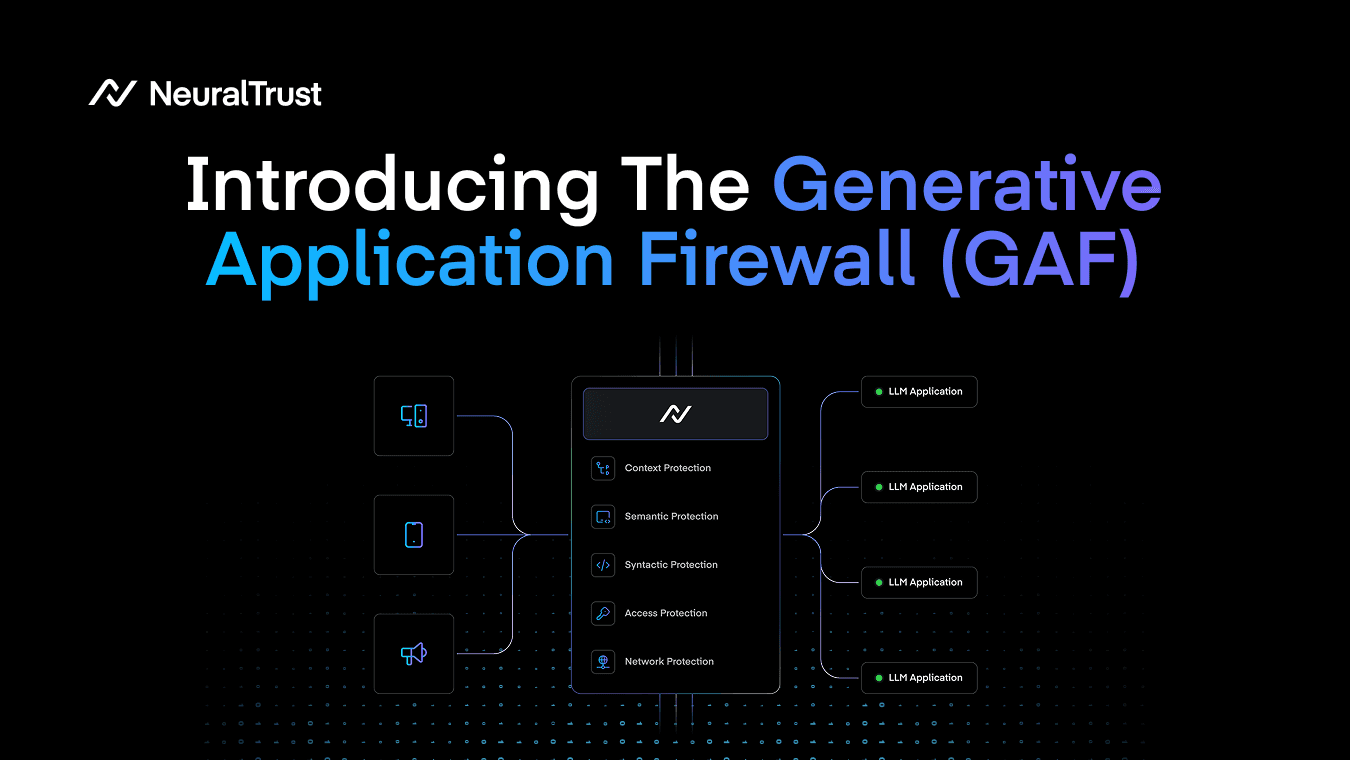

Hoy presentamos el Generative Application Firewall (GAF), una nueva capa arquitectónica para proteger aplicaciones impulsadas por LLM, incluidos los agentes autónomos y sus interacciones con herramientas.

Al igual que un Web Application Firewall (WAF) se volvió esencial cuando las aplicaciones web introdujeron nuevas superficies de ataque, las aplicaciones de IA generativa están creando ahora una brecha de seguridad igual de urgente. Las capas de seguridad tradicionales no fueron diseñadas para ataques que operan mediante semántica de lenguaje natural, manipulación de múltiples turnos y ejecución impulsada por herramientas.

GAF es nuestra respuesta a esa brecha: una capa unificada de aplicación de políticas que puede orquestar controles existentes, cubrir protecciones que faltan y proporcionar un único punto de aplicación de políticas para los sistemas generativos modernos.

A medida que la IA generativa pasa de las demos a los sistemas en producción, las organizaciones están desplegando asistentes para atención al cliente, productividad interna, generación de código, analítica y, cada vez más, agentes capaces de ejecutar acciones. Este es un cambio importante en cómo se comporta el software. Pero también cambia la forma en que los sistemas fallan.

Las amenazas que estamos viendo no se limitan a vulnerabilidades web clásicas. La IA generativa introduce ataques como la inyección de prompts, los jailbreaks y la manipulación del contexto, donde la carga maliciosa se parece a una solicitud normal de usuario a nivel de red e incluso a nivel de aplicación web. Por eso los controles existentes se quedan cortos:

- Los firewalls de red y los IDS (capa 3-4) inspeccionan señales a nivel de paquetes, pero la intención maliciosa puede viajar dentro de solicitudes HTTPS perfectamente legítimas.

- Los WAF tradicionales (capa 4-7) buscan patrones estructurados (inyección SQL, XSS, firmas), pero los ataques de GenAI a menudo no presentan anomalías evidentes en la carga.

- Los ataques de múltiples turnos pueden construir la intención de forma gradual, donde cada prompt individual parece inofensivo por sí solo.

El resultado es una “brecha semántica” en la seguridad de aplicaciones: un espacio donde el significado es la superficie de ataque y donde el stack de seguridad tradicional no tiene visibilidad.

¿Qué es un Generative Application Firewall (GAF)?

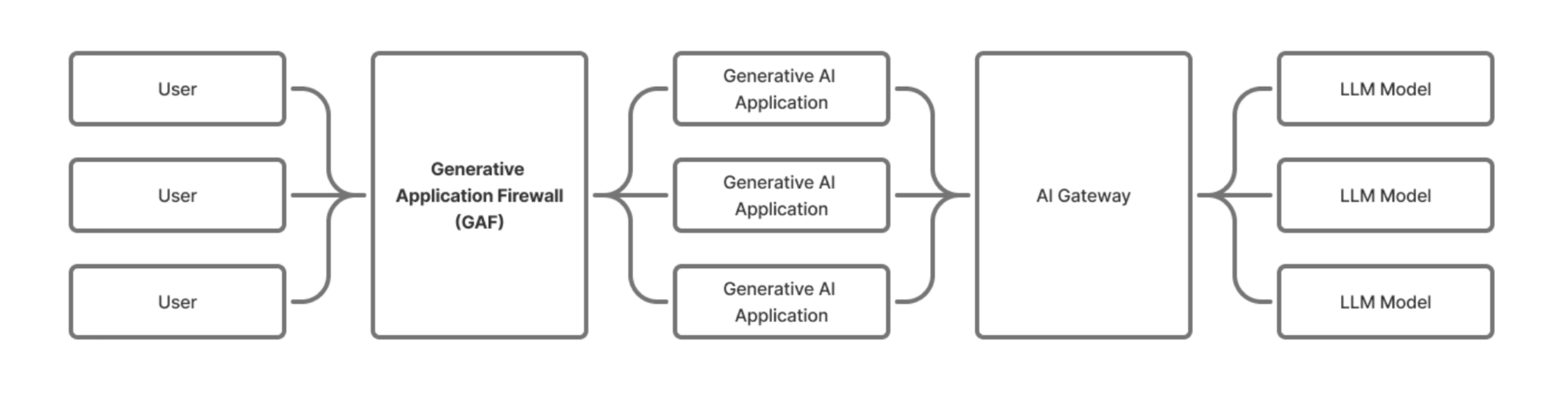

El Generative Application Firewall (GAF) es una capa de seguridad y control diseñada para aplicaciones que exponen una interfaz de lenguaje natural impulsada por LLM. Se sitúa entre el usuario y la aplicación LLM subyacente, actuando como un punto centralizado de aplicación de políticas de seguridad en todo el stack generativo.

A diferencia de los guardrails a nivel de prompt que evalúan una única solicitud, GAF mantiene una visión holística de usuarios, sesiones e interacciones a lo largo del tiempo, lo que permite controles más sólidos tanto para amenazas de un solo turno como para estrategias de escalada de múltiples turnos.

Y, de forma crítica, GAF no está diseñado solo para “chatear con un LLM”, sino también para sistemas agénticos. Puede interceptar llamadas a herramientas realizadas por agentes, aplicar políticas por herramienta y tratar las salidas de las herramientas como entradas no confiables para prevenir la inyección indirecta y el envenenamiento de datos.

Figure 1: GAF as centralized enforcement across Network, Access, Syntactic, Semantic, and Context layers.

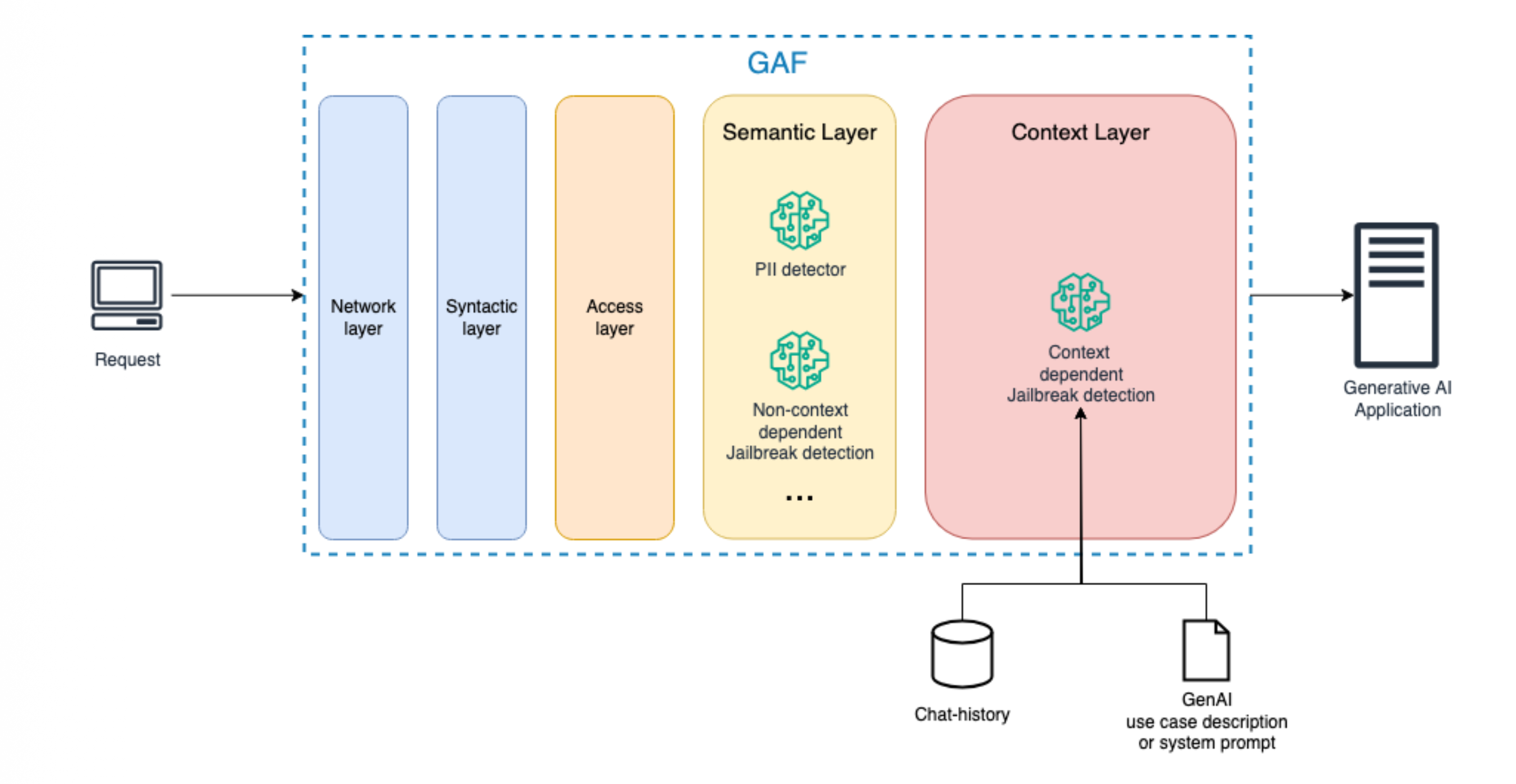

Un modelo de seguridad por capas para aplicaciones generativas

Un principio fundamental de GAF es que proteger interfaces de lenguaje natural requiere defensa en profundidad a través de múltiples capas, cada una orientada a una clase distinta de riesgos. Definimos cinco capas:

-

Network Layer: Límites de tasa, prevención de abuso, filtrado de IP y protecciones volumétricas para mitigar flooding, scraping, DoS e intentos de extracción.

-

Access Layer: Autenticación, autorización, aplicación de roles y políticas de mínimo privilegio para usuarios y agentes, incluyendo acceso a herramientas con alcance definido.

-

Syntactic Layer: Validación estructural de entradas y salidas, aplicación de esquemas para llamadas a herramientas, restricciones de formato y protección contra ofuscación y conformación de cargas tipo inyección.

-

Semantic Layer: Detección de ataques basados en significado que pueden identificarse a partir de un único prompt, incluidos patrones de jailbreak e intentos de inyección que se basan en formulaciones manipuladoras en lugar de firmas de código.

-

Context Layer: Protección longitudinal frente a jailbreaks de múltiples turnos y estrategias de escalada, realizando seguimiento del historial del diálogo, la intención del rol, patrones de comportamiento y bucles de planificación de agentes a lo largo del tiempo.

Esta estructura refleja lo que realmente son las aplicaciones generativas: no solo endpoints que reciben solicitudes, sino sistemas interactivos donde la intención evoluciona a lo largo de los turnos y las acciones pueden propagarse a través de herramientas.

Figure 2: The context layer is the most difficult part in defining a proper GAF architecture

Un nuevo estándar para la seguridad generativa

La IA generativa está transformando el software. Pero también está transformando el perímetro de seguridad. GAF aporta una capa arquitectónica que faltaba para las organizaciones que quieren desplegar aplicaciones generativas de forma segura, consistente y a escala: no parcheando defensas aisladas, sino construyendo un sistema unificado de aplicación de políticas que entiende el lenguaje, el contexto y las acciones.

Si estás trabajando en aplicaciones de IA, sistemas agénticos o gobernanza de GenAI, nos encantaría recibir tu feedback y colaborar en cómo debería evolucionar esta capa.

El artículo de investigación completo está disponible en arXiv.

Agradecimientos especiales a nuestro equipo de investigadores en NeuralTrust y a nuestros endorsers de élite por su apoyo y contribuciones: Christos Kalyvas-Kasopatidis (University of the Aegean), Emre Isik (University of Cambridge), Idan Habler (OWASP GenAI Security Project), Jinwei Hu (University of Liverpool), Strahinja Janjusevic (MIT Computer Science and Artificial Intelligence Laboratory), Osvaldo Ramirez (Center for AI and Digital Policy), Tu Nguyen (Huawei) y Xuanlin Liu (Cloud Security Alliance).